随机森林构造有哪些步骤?随机森林案例展示

更新时间:2021年09月16日17时11分 来源:传智教育 浏览次数:

在机器学习中,随机森林是一个包含多个决策树的分类器,并且其输出的类别是由个别树输出的类别的众数而定。

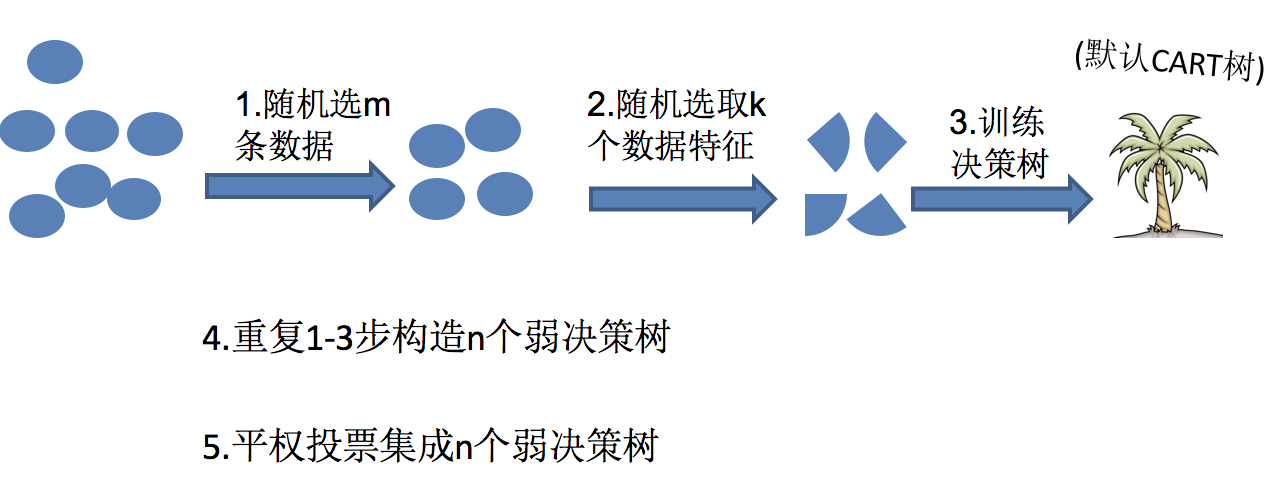

随机森林 = Bagging + 决策树

例如, 如果你训练了5个树, 其中有4个树的结果是True, 1个树的结果是False, 那么最终投票结果就是True随机森林够造过程中的关键步骤(M表示特征数目):

1)一次随机选出一个样本,有放回的抽样,重复N次(有可能出现重复的样本)

2) 随机去选出m个特征, m <

思考

1.为什么要随机抽样训练集?

如果不进行随机抽样,每棵树的训练集都一样,那么最终训练出的树分类结果也是完全一样的

2.为什么要有放回地抽样?

如果不是有放回的抽样,那么每棵树的训练样本都是不同的,都是没有交集的,这样每棵树都是“有偏的”,都是绝对“片面的”(当然这样说可能不对),也就是说每棵树训练出来都是有很大的差异的;而随机森林最后分类取决于多棵树(弱分类器)的投票表决。

随机森林api介绍

- sklearn.ensemble.RandomForestClassifier(n_estimators=10, criterion=’gini’, max_depth=None, bootstrap=True, random_state=None, min_samples_split=2)

- n_estimators:integer,optional(default = 10)森林里的树木数量120,200,300,500,800,1200

- Criterion:string,可选(default =“gini”)分割特征的测量方法

- max_depth:integer或None,可选(默认=无)树的最大深度 5,8,15,25,30

- max_features="auto”,每个决策树的最大特征数量

- If "auto", then

max_features=sqrt(n_features). - If "sqrt", then

max_features=sqrt(n_features)(same as "auto"). - If "log2", then

max_features=log2(n_features). - If None, then

max_features=n_features.

- If "auto", then

- bootstrap:boolean,optional(default = True)是否在构建树时使用放回抽样

- min_samples_split:节点划分最少样本数

- min_samples_leaf:叶子节点的最小样本数

- 超参数:n_estimator, max_depth, min_samples_split,min_samples_leaf

随机森林预测案例

实例化随机森林

# 随机森林去进行预测 rf = RandomForestClassifier()

定义超参数的选择列表

param = {"n_estimators": [120,200,300,500,800,1200], "max_depth": [5, 8, 15, 25, 30]}

使用GridSearchCV进行网格搜索

# 超参数调优gc = GridSearchCV(rf, param_grid=param, cv=2)

gc.fit(x_train, y_train)

print("随机森林预测的准确率为:", gc.score(x_test, y_test))

注意:

随机森林的建立过程

树的深度、树的个数等需要进行超参数调优

AI智能应用开发

AI智能应用开发 AI大模型开发(Python)

AI大模型开发(Python) AI鸿蒙开发

AI鸿蒙开发 AI嵌入式+机器人开发

AI嵌入式+机器人开发 AI运维

AI运维 AI测试

AI测试 跨境电商运营

跨境电商运营 AI设计

AI设计 AI视频创作与直播运营

AI视频创作与直播运营 微短剧拍摄剪辑

微短剧拍摄剪辑 C/C++

C/C++ 狂野架构师

狂野架构师